算力不再是瓶頸?MoE 架構如何為大型語言模型加速增效?

大型語言模型擴展的挑戰與MoE的崛起

大型語言模型(LLMs)近年來在自然語言處理、計算機視覺等多個領域取得了前所未有的進展,其強大能力主要源於龐大的模型規模、多樣化的訓練數據以及訓練過程中投入的巨大計算資源。這些模型展現出許多在小型模型中未曾出現的表現力,例如上下文學習(in-context learning),使得 LLMs 能夠執行越來越多的日常任務。

但是,這種規模的模型擴展並非沒有缺點。傳統的「密集模型」(Dense Models)在處理使用者的每個輸入時,會激活模型的所有參數,造成巨大的計算成本、推理速度變慢以及大量的記憶體消耗。隨著研究的持續深入、模型訓練參數從數十億增長到數千億甚至兆級,當計算呈指數級增長,對在實際應用中要求速度和可擴展性的部署就成了問題:問一個簡單的問題動用了模型大部分的運算資源,顯然有種殺雞用牛刀的意味在了。這種LLMs性能與其參數規模正相關,但計算成本和記憶體需求卻隨之急劇增加的現象,就形成了AI發展中的一個關鍵瓶頸,難道我們只能透過增加訓練量來讓我們的模型表現更好嗎?因此,尋求一種能夠在不犧牲性能的前提下,有效管理計算資源的架構創新成為 MoE 架構的研究動機。

為應對這些挑戰,專家混合模型(Mixture-of-Experts, MoE)架構應運而生,並迅速成為解決方案的焦點。MoE通過動態選擇和激活最相關的子模型來處理輸入數據,從而顯著提高模型性能和效率,同時減少資源消耗。MoE模型的核心理念是「分而治之」(divide and conquer),與傳統密集模型激活所有參數的策略截然不同。MoE 架構允許模型在不按比例增加計算成本的情況下,顯著擴展其容量並處理多樣化的知識領域,從而實現性能與效率之間的最佳平衡。這種架構的出現,有效地繞過了傳統密集模型在規模擴大時的計算瓶頸,允許模型在保持計算效率的同時,擁有巨量的參數,從而實現了性能上的突破。

此外,MoE的設計也反映了AI模型設計理念從通用性到專業化的演進。傳統密集模型追求的是單一模型的通用能力,試圖讓一個模型處理所有類型的輸入。MoE的「分而治之」策略則引入了專業化的概念,每個「專家」負責處理特定類型的數據或任務。這種轉變表明,在某些複雜場景下,專業化分工可能比單一通用模型更高效、更優越。這也預示著未來AI系統可能更傾向於模組化、可組合的設計,以應對日益複雜和多樣化的應用需求。

MoE架構核心概念解析

專家混合模型(MoE)是一種機器學習技術,它利用多個「專家網絡」(learners)將問題空間劃分為同質區域。它屬於集成學習(ensemble learning)的一種形式,也被稱為「委員會機器」(committee machines)。其核心思想是將複雜的任務分解為更小、更易管理的子任務,並由專門的「專家」模型來處理每個子任務 6。這種設計使得模型能夠在處理不同類型的輸入時,調用最適合的「專家」,而非讓單一的龐大模型處理所有情況。

我們可以將其比喻為一個頂尖的顧問團隊。團隊中有多位專家,各自精通不同領域,如財經、法律、醫療等。當客戶提出問題時,團隊的專案經理(門控網路)會先分析問題的性質,然後指派最相關的幾位專家(專家網路)來共同解決,而其他專家則可以繼續休息或處理其他事務。如此一來,不僅解決問題的效率和品質得以提升,整個團隊的運營成本也得到了有效的控制。

MoE的三大關鍵組成部分

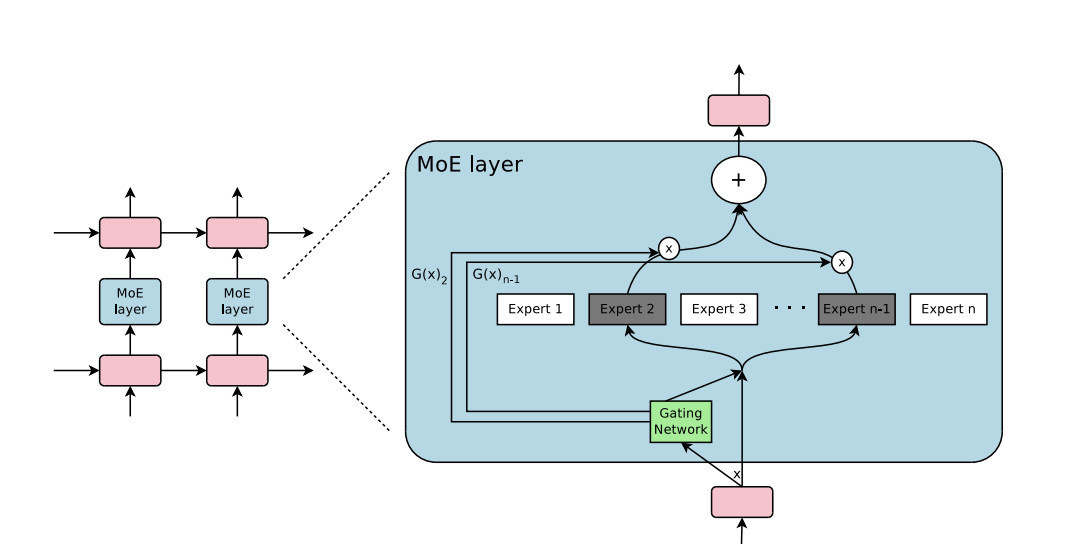

MoE架構的核心在於其模組化的設計,主要由三個關鍵組件構成:

- 專家網絡 (Expert Networks): 這些是MoE框架中的獨立模型或子網絡,每個專家都專注於輸入數據的特定方面或特定功能。例如,在語言模型中,一個專家可能擅長處理語法結構,而另一個可能專注於事實性知識。原則上,每個專家網絡都可以作為獨立的網絡模型運行,但實際上,為確保效率和可擴展性,它們通常被集成到一個單一網絡模型中,其中特定層(如Transformer中的前饋網絡FFN層)被MoE層取代。

- 門控網絡 (Gating Network / Router): 門控網絡是MoE架構的核心組件,它根據輸入數據的特性,動態地選擇並激活最相關的專家子集。它評估輸入並為每個專家分配權重,確保模型動態選擇最合適的專家組合以生成最佳輸出。在 Transformer 模型中,門控網絡為每個 token 產生一個分數,這些分數通常通過 softmax 函數轉換為概率,然後選擇得分最高的 Top-k 個專家進行處理 5。這個組件的學習能力對於MoE的整體性能至關重要,它決定了如何有效地將不同的輸入路由到最擅長處理它們的專家。

- 組合器 (Combiner):組合器負責將所選專家的輸出進行整合,以產生最終的模型輸出。通常,這是通過對所選專家的輸出進行加權求和來實現的,權重由門控網絡提供。這種加權求和機制確保了不同專家的貢獻能夠被有效地結合,形成一個連貫且高質量的最終響應。

| 組件名稱 (Component) | 功能 (Function) | 關鍵特性 (Key Characteristics) |

|---|---|---|

| 專家網絡 (Expert Networks) | 處理輸入數據的特定子集或特定任務,每個專家都專注於一個特定的知識領域。 | 獨立的子模型,通常是前饋網絡 (FFN),可集成到Transformer層中。 |

| 門控網絡 (Gating Network / Router) | 根據輸入數據的特性,動態地選擇並激活最相關的專家子集。 | 評估輸入並為每個專家分配權重,通常通過softmax函數實現Top-k選擇。 |

| 組合器 (Combiner) | 將所選專家的輸出進行整合,以產生最終的模型輸出。 | 通常是根據門控網絡提供的權重對專家輸出進行加權求和。 |

稀疏激活與條件計算

MoE模型的一個關鍵優勢是稀疏激活(Sparse Activation),這源於條件計算(Conditional Computation)的概念。與傳統的「密集」模型不同,密集模型無論輸入是什麼,都會激活所有參數,造成大量冗餘計算。MoE 則通過門控網絡的智能路由,選擇性地激活網絡中必要的參數或專家子集。這意味著對於每個輸入,只有一小部分專家會被查詢和計算,從而大大減少了計算需求,同時保持了性能。這種稀疏性是效率的基石,而非偶然。MoE的設計哲學是基於對計算資源的精準分配,而非盲目擴大模型規模。

MoE在Transformer架構中的應用

在Transformer架構中,MoE層通常通過替換原有的前饋網絡(FFN)層來引入。FFN層由於其更高的稀疏性和領域特異性,被認為是引入MoE機制的理想選擇。研究表明,FFN層在 Transformer 中表現出更高的稀疏性,且神經元激活與特定任務之間存在顯著關聯,這進一步激發了利用 MoE 結構來反映預訓練 Transformer 模塊化性質的想法。這種MoE的「分而治之」策略與Transformer的「模塊化」是天然契合的。Transformer模型中的FFN層本身就表現出模塊化和任務相關性的特性,這意味著Transformer的內部結構已經具備了專業化分工的潛力。MoE架構恰好利用了這一點,將FFN層替換為專家層,使得這種潛在的模塊化能力得以顯式地發揮出來。提高了效率之餘,也可能增強模型處理多樣化任務的能力,因為不同的專家可以專注於不同的語言模式、知識領域或任務類型。

每個Transformer層都可以有自己的路由器和一組專家。這種層級化的專業化允許模型在其架構中發展出複雜的專業知識模式。例如,在第一層,某個token可能被路由到處理語法結構的專家,而在第二層,同一個token可能被路由到處理語義理解的專家。這種動態路由在模型的每一層持續進行,逐步完善對輸入的表示。

3. MoE架構的優勢與挑戰

MoE架構的引入是為了解決傳統密集模型在規模擴大時的計算效率問題。它通過稀疏激活實現了顯著的計算資源節省和模型容量擴展。然而,這種效率並非沒有代價:它引入了新的訓練複雜性,特別是負載平衡問題,以及對記憶體和實施的新要求。這表明AI架構設計是一個不斷權衡和優化的過程,解決一個問題往往會引發新的挑戰。

MoE的顯著優勢

MoE模型因其獨特的設計帶來了多方面的優勢,使其成為大型語言模型發展的有力推動者:

- 計算效率與資源節省 (Computational Efficiency & Resource Savings): MoE模型的主要優勢之一是其稀疏激活特性。與密集模型不同,MoE僅激活每個輸入的一小部分專家,從而顯著減少了所需的計算量。這種選擇性激活大幅降低了總體計算負擔,節省了記憶體和處理能力,尤其對於大型模型至關重要。例如,Mistral 8x7B模型雖然總參數達1660億,但在推論時每個token僅使用兩個專家,使其AI處理更高效。這種效率提升直接轉化為更低的運營成本和更快的響應時間。

- 模型容量與可擴展性 (Model Capacity & Scalability): MoE允許通過增加更多專家來擴展模型容量,而計算成本不會按比例增加。這使得MoE非常適合大規模應用,能夠處理更複雜的任務和更廣泛的數據類型。例如,Google的Switch Transformer模型參數高達1.6兆,通過MoE機制在保持效率的同時處理了大量計算任務。這種模組化增長的能力,使得MoE模型能夠在不增加單次推論計算量的前提下,不斷學習和容納更多的知識。

- 專業化與適應性 (Specialization & Adaptability):每個專家都針對數據的特定子集進行訓練,從而實現更好的泛化能力。模型可以根據輸入動態選擇最合適的專家,從而提高在不同領域的性能。這種設計增強了模型的整體性能、泛化能力和計算效率,尤其是在處理複雜多樣的任務時。這種專業化使得模型能夠更精準地處理特定類型的問題,避免了單一通用模型可能出現的「萬金油」但「不精通」的困境。

- 訓練與推論速度 (Training & Inference Speed): MoE模型通常比具有相似性能的密集模型訓練更快、成本更低。由於選擇性激活,MoE在推論時也更高效,對於相同有效模型大小,生成速度更快 5。這對於需要快速響應的實時應用至關重要,同時也降低了模型開發和部署的總體成本。

4. 主流大型語言模型中的MoE應用與比較

MoE架構的成功應用已經在當前領先的大型語言模型中得到體現,這也表明其已成為下一代LLM設計的主流趨勢。

採用MoE架構的知名LLMs

多個領先的LLM已經採用或正在探索MoE架構,以實現更高的效率和性能:

- Grok-1 (xAI): Grok-1是xAI訓練的一個擁有3140億參數的MoE大型語言模型。其設計特點是在推論時僅激活25%的權重。Grok-1在推理和編碼任務上表現出強大能力,儘管在某些基準測試中仍落後於GPT-4。Grok AI系列(從Grok-1到Grok-3)展示了深度學習架構、效率和實際應用方面的顯著改進。

- Gemini (Google): Google的Gemini 1.5和Gemini 2.5模型系列採用稀疏專家混合(Sparse Mixture-of-Experts, SMoE)Transformer架構,並原生支持多模態輸入,包括文本、視覺和音頻。這種新架構使Gemini 1.5在訓練和服務方面更高效,能夠將請求路由到一組較小的「專家」神經網絡,從而實現更快的響應和更高的質量。Gemini 1.5 Pro在性能上與Google迄今為止最大的模型1.0 Ultra相當,並引入了長上下文理解的突破性實驗功能,標準上下文窗口為128,000 token,部分用戶可達100萬token。

- GPT-4 (OpenAI):儘管OpenAI尚未公開GPT-4的技術細節和統計數據,但業界普遍認為GPT-4部署了MoE模型。據廣泛推測,GPT-4是一個擁有1.76兆參數的MoE模型,比GPT-3大一個數量級。它可能包含16個專家模型,每個約1110億參數。在推論時,僅需要約2800億參數和560 TFLOPs的計算量,遠低於純密集模型所需的1.8兆參數和3,700 TFLOPs。這種MoE設計被認為是GPT-4實現其卓越性能和效率的關鍵。OpenAI對GPT-4的架構細節始終沒有透露,但業界和研究界普遍認為它是MoE模型。這種「未公開」與「普遍共識」之間的張力,反映了AI領域競爭的激烈性,以及MoE技術在實現GPT-4級別性能中的關鍵作用。

MoE的專業化特性,使得模型能夠更高效地處理特定領域或任務。隨著MoE技術的成熟和普及,可能會看到更多針對特定行業或應用場景優化的LLM出現,例如專為金融、醫療或法律領域設計的「專家」模型。這將加速AI在各行各業的深度融合,並可能催生出更多創新性的、高度專業化的AI應用。MoE不僅是技術上的創新,更是AI模型設計理念的演進,它將引領我們走向更高效、更專業、更具可擴展性的智能系統。