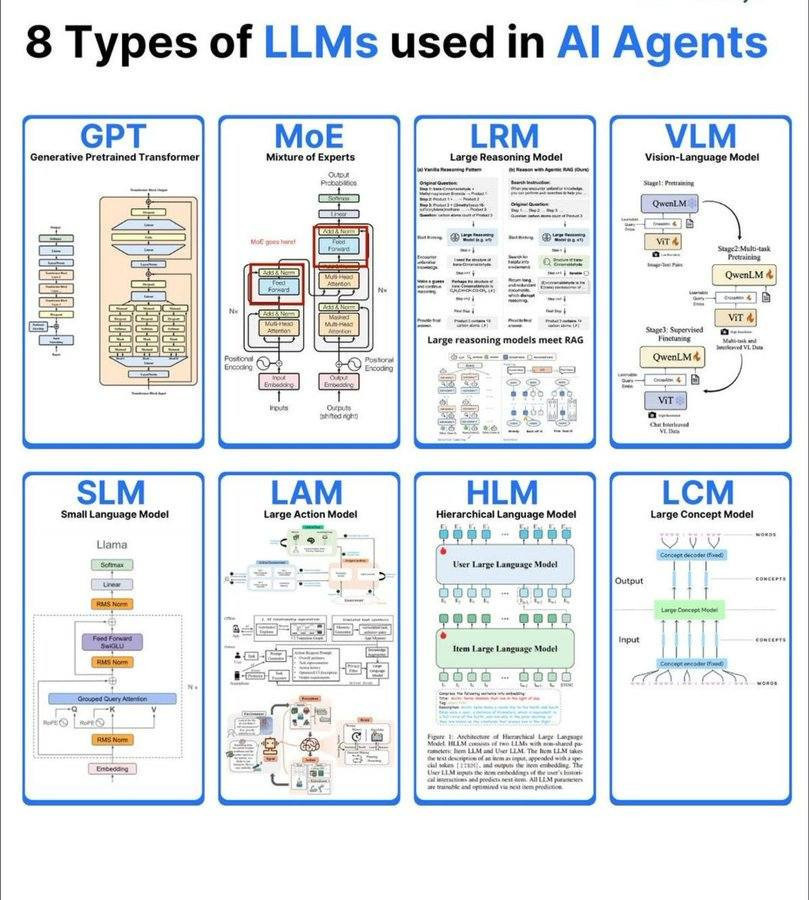

驅動智能體革命的八大語言模型:LLM 架構全解析 ep.1

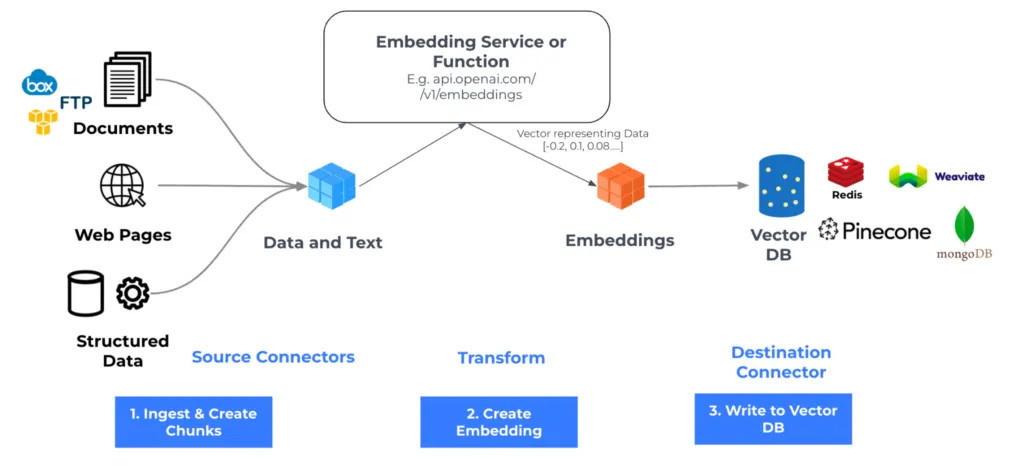

在人工智慧(AI)快速演進的時代,「AI Agent(人工智慧智能體)」成為生成式 AI 的新核心。不同於僅能回應指令的聊天機器人,AI Agent 能自主規劃、決策與執行任務,而其「思考引擎」正是多樣化的大型語言模型(Large Language Models, LLMs)。

隨著 AI 技術不斷分化與專精,LLM 已從單純的文字生成模型,發展為能處理多模態輸入、邏輯推理甚至自主行動的多功能架構。本文將介紹 AI 智能體中最具代表性的八種類型 LLM,並深入解析其原理、架構與應用場景。本文首先從四種關鍵類型開始:GPT、MoE、LRM 與 VLM。

1. 生成預訓練變換器(GPT)

想必大家對於這個詞都不陌生:生成預訓練變換器(Generative Pre-trained Transformer,GPT)是大型語言模型(LLM)家族的先驅,基於Transformer深度學習架構,由OpenAI開發而成。專注於自然語言處理(NLP)任務,能模擬人類生成的輸出,驅動如ChatGPT等生成式AI工具。從2018年的GPT-1起步,到2024年的GPT-4o(支援多語言與多模態,包括即時處理音頻、視覺與文本輸入),GPT已成為AI代理的基礎模型。透過API連接應用程式,GPT加速生成式AI開發,讓代理具備類人文本生成能力,處理對話、內容創作與決策支援。

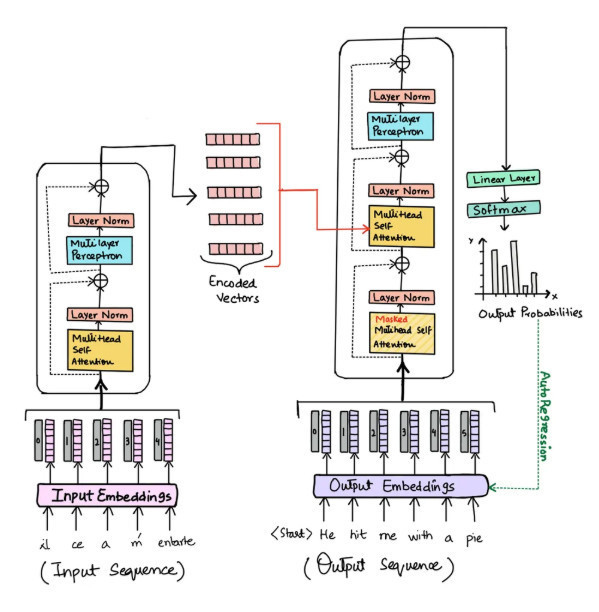

GPT的架構建立在Transformer基礎上,這是一種擅長序列數據處理的神經網路。核心組件包括自注意力機制(self-attention),允許模型同時處理整個輸入序列,聚焦重要標記(tokens)而不受位置限制,從而捕捉長程依賴關係,優於傳統的遞迴神經網路(RNN)或卷積神經網路(CNN)。編碼器(encoders)將標記映射至三維向量空間(embeddings),其中語義相近的標記位置接近,並透過位置編碼器區分詞序(如「雞先蛋後」與「蛋先雞後」的差異)。解碼器(decoders)則基於編碼嵌入,預測最可能的輸出序列,利用自注意力生成連貫回應。GPT將詞彙拆分成標記(某些詞可能拆成多個),並透過深度學習從訓練數據中學習脈絡。

圖1:GPT基於Transformer的編碼器-解碼器架構,強調自注意力機制

訓練GPT強調生成式預訓練,使用無標籤數據進行無監督學習,讓模型偵測模式並生成預測。模型擁有數十億至萬億參數(GPT-4估計1.8萬億,較GPT-3.5增加十倍),預訓練依賴海量公開數據集,如文學作品與開源程式碼,模擬人類語言。從GPT-3起,引入先進效率方法,降低計算與能源成本。後續微調(fine-tuning)則針對下游任務調整模型,透過API實現。整體過程資源密集,但使AI代理能從無結構數據中提取洞見。

2. 專家混合模型(MoE)

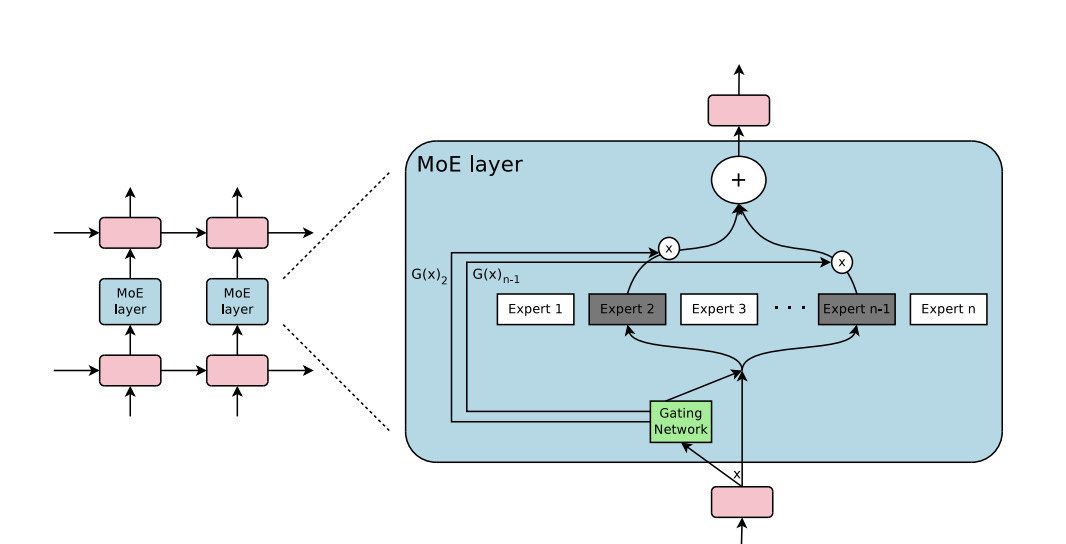

專家混合模型(Mixture of Experts,MoE)是一種機器學習方法,將人工智慧(AI)模型分解為多個獨立的子網路(或稱「專家」),每個專家專精於輸入數據的特定子集,共同完成任務。這項架構讓大型模型—甚至那些擁有數十億參數的模型—能在預訓練期間大幅降低計算成本,並在推理階段實現更快效能,透過僅激活特定任務所需的專家,而非整個神經網路。在AI代理中,MoE提升了可擴展性與效率,讓代理能處理多領域任務,如自然語言處理(NLP)中的動態決策或多模態輸入路由,模擬人類專家分工,適用於自主系統的資源優化。

MoE的起源可溯及1991年的論文《Adaptive Mixture of Local Experts》,提出由多個專門網路組成的AI系統,加上一個閘控網路(gating network)決定每個子任務的專家選擇。相較於傳統模型訓練速度快一倍,達到目標準確度僅需一半的迭代。在現代深度學習中,MoE解決了大型模型容量與小型模型效率的權衡,尤其在大型語言模型(LLM)中,如Mistral的Mixtral 8x7B(據報導OpenAI的GPT-4也採用)。與密集模型(dense models)不同,MoE透過條件計算(conditional computation)實現稀疏性:一個低計算成本的映射函數(路由器)根據輸入(如NLP任務中的標記)決定最有效的專家部分,從而增加模型容量(總參數)而不成比例增加計算負荷。

MoE的架構將專家視為子網路,一個閘控網路激活適合的專家。稀疏性透過替換密集前饋神經網路(FFN)層為稀疏MoE層(塊)實現,這些塊可為單層、自包含FFN或嵌套MoE。例如,在Mixtral 8x7B中,每層有8個前饋塊(專家),每個7億參數;路由器每標記每層選擇2個專家,結合其輸出傳遞至下一層。專家選擇可能跨層變化。MoE模型可能混合稀疏與密集塊;在Mixtral中,自注意力塊跨專家共享。總參數計數(稀疏參數計數)衡量容量(如Mixtral約47億總參數,而非56億);活躍參數計數衡量計算成本(如Mixtral單標記活躍12.9億,出自46.7億可存取)。Mixtral在多數基準上優於Meta的70億參數Llama 2,速度更快,使用三分之一總參數且推理時活躍不到20%。

圖2:MoE架構,包括專家子網路、閘控路由器與頂-k選擇機制

訓練MoE涉及專家子網路與閘控網路的聯合訓練,透過稀疏性以恆定計算增加容量。挑戰包括複雜度;傳統頂-k路由可能收斂至少數專家,導致不平衡(過度訓練專家,其他成「死重」)。緩解方法包括:噪音頂-k閘控(添加高斯噪音增加隨機性與均勻激活);正則化項最小化負載平衡損失(懲罰過度依賴單一專家)與專家多樣性損失(獎勵均等利用)。Google的2020年論文《GShard》引入隨機路由(第二專家半隨機,按權重比例)與專家容量(每專家標記閾值;溢出跳至下一層)。微調MoE複雜且易過擬合,較密集模型不穩定;專家數少者微調更好,因多專家助預訓練但阻礙下游專精。2022年論文《ST-MoE》比較方法:全參數、非MoE僅、MoE僅、注意力僅或非MoE FFN僅;全與非MoE無差;注意力微降;MoE僅惡化效能(稀疏層佔80%參數但更新不全面);FFN改善基準,因專家層僅四分之一且每標記最多見兩專家,孤立更新易過擬合。指令微調(instruction tuning)對MoE益處更大;2023年論文《Mixture-of-Experts Meets Instruction Tuning》顯示,Flan-MoE優於Flan-T5,且改善幅度大於Flan-T5對T5。這催生Mixtral 8x7B Instruct,作為IBM watsonx.ai的指令微調變體。

在AI代理應用中,MoE的效率使之適合代理任務,如處理輸入路由以實時決策。整合LLM(如watsonx.ai中的Mixtral)支援代理服務;IBM watsonx Orchestrate使用MoE設計可擴展AI助理,自動化重複任務並簡化流程。AI解決方案與諮詢將MoE融入工作流程,實現商業價值,如在高維數據(如NLP序列)中稀疏處理,提升代理在電腦視覺或多模態任務的效能。

知名MoE範例包括Mistral的Mixtral 8x7B(8專家/層,每7B參數,總~47B,頂-2路由,基準優於Llama 2 70B且更快);OpenAI的GPT-4(據報採用MoE);Switch Transformers(基於T5,達128專家,k=1硬路由,萬億參數預訓練速度提升400%);以及Mixtral 8x7B Instruct(指令微調Flan-MoE變體,在IBM watsonx.ai提供)。這些模型在2025年廣泛整合至AI代理框架,支持高效多領域處理。

MoE的效能透過基準測試驗證,聚焦容量、速度與任務準確度。Mixtral 8x7B在多數基準上優於Llama 2 70B,儘管總參數少三分之一且活躍 20%;Switch Transformers在T5上預訓練速度提升400%;ST-MoE比較顯示FFN微調改善基準,MoE僅惡化。指標包括活躍參數計數、負載平衡、專家利用率與下游任務效能,強調稀疏性不損失效能。

儘管強大,MoE仍面臨挑戰:訓練與微調複雜度(易過擬合與不穩定,需噪音/正則化緩解);路由風險(專家不平衡,透過隨機路由與容量閾值改善);微調不穩定(專家數多者差,指令微調助益);記憶需求(全參數載入RAM/VRAM,效率不適用記憶);參數計數誤導(如「8x7B」非真56B)。其他包括死專家問題與高維數據挑戰,促使開發者強化路由機制與混合訓練,讓MoE更可靠地應用於AI代理生產環境。

3. 大型推理模型(LRM)

大型推理模型(Large Reasoning Models,LRM)是大型語言模型(LLM)的進階變體,專門透過細調來將複雜問題拆解成較小的「推理軌跡」(reasoning traces),在產生最終輸出前先進行中間推理步驟。這類模型不再立即回應用戶輸入,而是先「思考」多步驟推理,模擬人類的逐步邏輯過程,從而大幅提升在複雜推理任務上的效能。在AI代理中,LRM強化了決策能力,讓代理能處理邏輯驅動的任務,如數學求解、程式碼除錯或策略規劃,標誌著生成式AI從直覺式回應轉向可驗證的「展示工作過程」,擴大應用於需要透明度的領域,如科學研究與自動化決策系統。

LRM的架構建立在基礎LLM之上,通常經過指令細調後,融入增加測試時計算(test-time compute)的機制,透過多步決策策略生成中間推理步驟。它們廣泛採用思維鏈(Chain-of-Thought,CoT)推理技術,將問題分解為可追蹤的步驟。與標準LLM不同,LRM使用兩種主要方法提升推理時計算:生成更長輸出(透過長思維鏈、回溯與自我精煉)或生成多個輸出(透過搜尋、拒絕與聚合潛在回應)。架構整合強化學習(RL)來激勵這些推理行為,常針對可驗證問題如程式碼或數學任務進行訓練。有些LRM會向用戶展示完整推理軌跡,其他則僅摘要或隱藏中間輸出,以平衡透明度與效率。這不僅解鎖LLM從訓練數據中隱含學習的推理能力,還提升了模型在高複雜度任務上的泛化。

圖3:LRM基於LLM的架構,強調思維鏈生成與強化學習整合

訓練LRM的前期階段與傳統LLM相似:大規模自監督預訓練以建立語言流暢性與世界知識,接著進行監督式細調(SFT)針對下游任務。核心創新在於應用新型RL技術來激勵中間推理步驟,包括基於規則的RL(適合靜態任務)與深度RL(適合動態環境)。LRM遵循聊天機器人的訓練管道(自監督預訓練、SFT、指令調優、RLHF),但額外增加RL階段,定義目標並優化權重以最大化獎勵,灌輸CoT推理。獎勵訊號分為三類:結果獎勵模型(ORMs,驗證最終輸出準確性,類似損失函數但處理CoT變異性);過程獎勵模型(PRMs,對個別推理步驟計分,提供細粒度訊號但成本高,常需人類註解或自動推斷);以及基於規則的獎勵系統(如格式化答案於方框中,或激勵微行動如「等待」探索)。特定方法包括DeepSeek-R1-Zero的純RL(使用簡單規則提示思維與答案標籤,獎勵準確性與格式,產生複雜CoT但易重複);搜尋與抽樣方法(如蒙地卡羅樹搜尋MCTS探索多步,或自一致性抽樣多CoT並投票);以及SFT、知識蒸餾與自我改善(如STaR從少樣本迭代正確推理,或ReST的強化自我訓練)。訓練聚焦可驗證領域,如數學與程式碼,主觀領域如創意寫作研究較少。

在AI代理應用中,LRM擴大邏輯驅動任務的範圍,提升複雜問題解決效能,避開標準LLM的認知捷徑並浮現相關知識。用例包括多步推理任務,如數學證明、程式碼生成或決策模擬,其中系統2思維(緩慢、深思熟慮)優於系統1(快速、直覺)。它們驅動生成式AI與AI代理的進展,適用於需可驗證解決方案的領域,如軟體開發(代理自動除錯)或財務規劃(步驟式風險評估)。在代理環境中,LRM支援工具整合與規劃,實現端到端自動化,但主觀任務如敘事生成仍需混合方法。

知名LRM範例包括OpenAI的o1-preview與o1-mini(2024年9月引入概念,專注CoT推理);Alibaba的Qwen with Questions(QwQ-32B-preview,2024年11月發布);Google的Gemini 2.0 Flash Experiment(2024年12月);DeepSeek-R1(2025年1月開源里程碑,純RL基礎);IBM Granite(2025年2月發布Granite 3.2,具可切換思維模式,使用思維偏好優化TPO);Anthropic的Claude 3.7 Sonnet(2025年2月,細粒度思維控制);以及Mistral AI的推理LLM(DeepSeek後發布)。其他包括從DeepSeek-R1知識蒸餾的Qwen與Llama變體。這些模型在2025年已廣泛整合至AI代理框架,支持高複雜度任務。

LRM的效能透過邏輯驅動任務的基準測試驗證,使用可驗證解決方案評估準確性、格式與推理穩健性。特定基準包括ArenaHard與Alpaca-Eval-2,其中某些推理細調模型(如Llama 3.1、Qwen2.5)顯示退化;CoT提示顯著改善數學/程式碼任務,但主觀領域影響小。指標涵蓋準確率、推理軌跡品質與泛化能力,研究顯示RL與CoT解鎖潛在能力,但低複雜任務或超出閾值問題仍失效。

儘管強大,LRM仍面臨挑戰:過度思考(Tencent研究顯示每回應令牌增加1,953%,易循環推理而非工具使用);推理擴展限制(Anthropic 2025年7月研究顯示長推理反向擴展,Apple 2025年6月質疑泛化);非推理領域退化(ArenaHard/Alpaca-Eval-2效能下降,TPO對數學/程式碼影響小但改善指令遵循);成本與延遲增加(思維令牌消耗計算,縮減上下文視窗,不宜任務切換模型);以及可解釋性(軌跡提升理解,但Anthropic研究顯示模型不總忠實解釋,遺漏提示)。其他包括主觀領域適用性低與訓練資源需求,促使開發者強化混合訓練與動態獎勵,讓LRM更可靠地應用於AI代理生產環境。

4. 視覺語言模型(VLM)

視覺語言模型(Vision Language Models,VLM)是多模態AI系統的核心,融合電腦視覺與自然語言處理(NLP)能力,讓AI代理能夠同時處理圖像、影片與文本輸入,從而產生更豐富的輸出,如圖像描述、視覺問答或物件識別。這類模型不僅擴展了AI代理的感知邊界,還使其在複雜環境中實現「看懂並回應」的智能互動,例如在自動駕駛或醫療診斷中,代理可根據視覺輸入生成決策報告。

VLM的架構主要由兩個關鍵組件組成:語言編碼器與視覺編碼器。語言編碼器負責捕捉詞彙與短語的語義關聯,將其轉換為可處理的文本嵌入(embeddings),多採用Transformer架構,如Google的BERT或OpenAI的GPT系列,透過自注意力機制(self-attention)聚焦輸入序列中最相關的元素。視覺編碼器則提取圖像或影片的視覺特徵,如顏色、形狀與紋理,並轉換為向量嵌入。早期VLM依賴卷積神經網路(CNN),但現代模型轉向視覺Transformer(ViT),將圖像切割成補丁(patches)並視為序列,應用自注意力機制生成Transformer式的視覺表示。這讓VLM能高效處理高解析度輸入,提升AI代理在視覺任務中的準確性。

圖4:典型VLM架構,包括語言編碼器、視覺編碼器與多模態整合層

訓練VLM時,重點在於對齊視覺與語言模態,讓模型學習圖像-文本的關聯。常見策略包括對比學習(contrastive learning),如CLIP模型,使用4億張圖像-標題對訓練,將匹配對的嵌入拉近、非匹配對推遠,實現零樣本分類(zero-shot classification)。遮罩學習(masking)則讓模型預測隱藏的文本或像素,例如FLAVA模型結合遮罩與對比學習,使用跨注意力(cross-attention)整合模態。生成式訓練則聚焦數據產生,如DALL-E的文本到圖像生成,或圖像到文本的描述生成。此外,從預訓練模型出發可降低成本,例如LLaVA使用Vicuna LLM與CLIP ViT,透過線性投影層(linear projector)融合輸出。訓練數據常來自ImageNet(數百萬註釋圖像)、COCO(大規模標題與物件檢測)或LAION(數十億多語言圖像-文本對),確保AI代理在多樣化場景中泛化。

在AI代理應用中,VLM的用例廣泛而實用。首先,圖像標題與摘要化可生成詳細描述,用於醫療影像分析或製造業設備維修圖表。其次,圖像生成工具如Midjourney或Stable Diffusion,協助代理在設計階段視覺化產品原型。圖像搜尋與檢索則讓代理根據自然語言查詢,從龐大資料庫中擷取相關內容,提升電商購物體驗。圖像分割與物件檢測支援空間分析,例如代理在機器人環境中識別物件位置,或在預測維護中標記工廠缺陷。視覺問答(VQA)則展現視覺推理能力,如交通代理分析道路影片,識別坑洞並生成維護報告。

知名VLM範例包括DeepSeek-VL2(開源,4.5億參數,使用MoE架構處理多模態理解);Gemini 2.0 Flash(Google系列,支援音頻、圖像與影片輸入);GPT-4o(OpenAI端到端訓練,處理混合模態輸出);Llama 3.2(Meta開源,11億與90億參數,使用ViT與跨注意力適配器);NVLM(NVIDIA系列,混合解碼器與跨注意力,提升高解析度效率);以及Qwen 2.5-VL(Alibaba,72億參數,能處理小時級影片與介面導航)。這些模型在2025年已廣泛整合至AI代理框架中。

VLM的效能透過基準測試驗證,如MathVista(視覺數學推理)、MMBench(多維度選擇題,包括OCR與物件定位)、MMMU(跨學科多模態理解)、MM-Vet(能力整合評估)、OCRBench(OCR專屬)與VQA(開放式圖像問答)。工具如VLMEvalKit或LMMs-Eval簡化評估流程。

儘管強大,VLM仍面臨挑戰:偏見(源自訓練數據,需多樣化來源與人類監督緩解);成本與複雜度(需大量計算資源,企業須投資基礎設施);泛化不足(對新數據適應差,可用零樣本學習與動態基準如LiveXiv改善);以及幻覺(輸出不準確,需驗證機制)。這些挑戰促使開發者強化VLM的安全性與可解釋性,讓AI代理更可靠地應用於生產環境。