GPU 和 CPU 到底有什麼不一樣?為什麼所有大模型都用GPU做運算呢?

在人工智慧 (AI)、機器學習 (Machine Learning)、以及深度學習 (Deep Learning) 快速發展的今天,GPU 已經成為訓練大型模型時不可或缺的工具。那麼,GPU 與 CPU 到底有什麼不同?為什麼現代的大型 AI 模型幾乎都使用 GPU 來進行運算?

什麼是運算?

在了解 CPU 和 GPU 的差別之前,我們先來釐清一個常見但可能有些抽象的詞:運算(Computation)。簡單來說,運算就是電腦用來處理資訊的方式。電腦不像人類會思考,它只是按照一條條指令,將資料轉換成你想要的結果。

舉例來說:

- 當你打開一張照片時,電腦就像是在拼拼圖,會把每一塊顏色(像素)放到正確的位置,組合成你看到的畫面。這整個過程,其實就是一種運算。

- 當你輸入 2 + 3 時,電腦會像計算機一樣,依照指令把數字加起來,再把結果 5 顯示出來,這也是一種運算。

- 當你問 ChatGPT 問題時,電腦會像在圖書館翻找資料一樣,從記憶中挑出最相關的內容,重新整理成有邏輯的回答。這背後同樣包含了大量的運算行為。

這些看似簡單的動作,其實電腦都在快速地、精確地執行數以千萬計的數學計算與邏輯判斷。而負責這些工作的核心元件,就是 CPU 和 GPU。

什麼是 CPU ? 它的強項在哪裡?

CPU (Central Processing Unit),也稱作中央處理單元,可以稱作是電腦的大腦,負責執行大部分複雜的指令。

它的運作方式就像辦公室裡的幾位資深員工,每個人能力很強,能處理複雜的任務,但人數不多,只能同時處理幾件事。CPU 裡的核心 (Core) 就是這幾位資深員工,一般電腦通常配備 4 到 16 個核心。大多數人的日常用途像是上網、寫報告、使用 Excel,甚至播放影片,使用的資源非常有限,因此只需要 4 核心的 CPU 就非常足夠了。太多核心反而用不上,還可能增加成本與耗電,對一般使用者來說沒有太大意義。

CPU 的設計重點是強調單核心效能,也就是每個核心在處理單一工作時的速度與效率。它特別適合執行流程固定、步驟清楚的任務,例如系統管理或應用程式的執行流程,因此常被視為一種萬能型但細膩的處理單元。

什麼是 GPU ? 為什麼它能加速運算?

CPU 核心數少,但每個核心非常強大,適合處理一件很複雜的事。而 GPU 的設計理念正好相反:GPU 的設計不是強化每一個核心的能力,而是放入大量簡單的核心,讓它們可以同時處理大量重複的任務。

這就像工廠生產線:

- CPU 就像是幾位經驗豐富的工程師,能夠解決困難問題,但一次只能處理一小批工作

- GPU 則像是一大群搬運工人,每個人各司其職。雖然不如 CPU 那些資深工程師聰明靈活,但人多勢眾、分工明確,因此整體效率反而更高

GPU (Graphics Processing Unit) ,又稱圖形處理單元,原本是為了圖像顯示而設計的,後來因為其架構的特性,被廣泛應用在 AI 訓練、科學計算等領域。

GPU 擁有數百到上千個核心,雖然每個核心不如 CPU 強,但能同時平行處理 (Parallel Processing) 大量小任務。這種架構非常適合像 AI 模型這種需要重複大量簡單運算的工作。在 AI 訓練中,最常見的計算之一就是矩陣運算 (Matrix Multiplication),這些矩陣運算可以想像成,電腦在處理一張又一張由數字組成的表格,每一張都要做加法、乘法等計算,再把結果輸出到下一層。GPU 擅長的就是這種重複而大量的運算,能同時處理上千組矩陣,大幅提升整體運算效率。

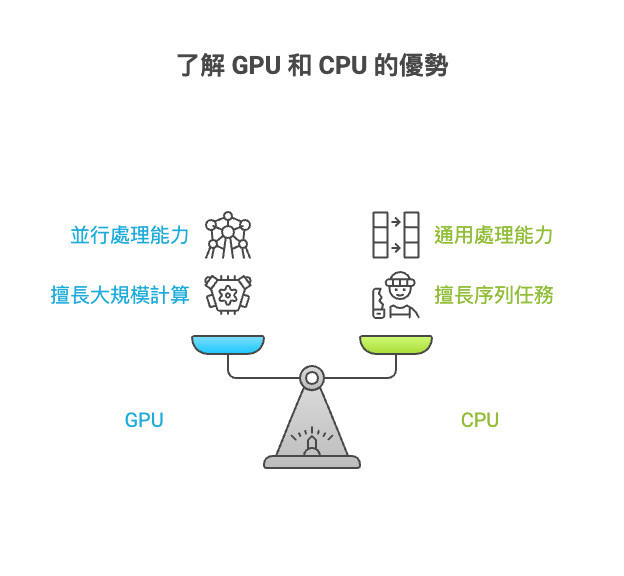

CPU vs GPU

| CPU | GPU | |

|---|---|---|

| 核心數量 | 一般 4 至 16 顆,性能強但數量少 | 數百到上千個,數量龐大 |

| 運算方式 | 擅長單核心計算、序列處理 | 擅長多核心計算、平行處理 |

| 擅長任務 | 系統控制、文書作業、複雜邏輯 | 矩陣運算、AI 訓練、影像渲染 |

| 應用場景 | 一般筆電、日常辦公 | 科學運算、深度學習、影像影片處理 |

為什麼用訓練 AI 大模型時需要使用 GPU?

訓練 AI 模型的過程,其實就像是慢慢教電腦理解這個世界。為了讓模型變得更「聰明」,電腦必須分析大量資料,並透過不斷的計算來調整內部的參數。這些計算的核心,其實就是大量的矩陣運算和微分處理。

我們可以用一個例子來想像這個過程:假設你要訓練 AI 分辨貓和狗,你會丟給它幾十萬張照片。每一張圖片會先被轉換成數字 (通常是幾百到幾千個),這些數字會組成像表格一樣的資料結構,也就是矩陣。接著,這些矩陣會被送進模型中,經過一層層的計算與比對,讓 AI 學會辨認出貓與狗的差異。

整個過程雖然每個動作都不難 (大多是加減乘除的計算),但次數非常驚人:每張圖片、每段文字都要重複跑過上百次以上,這種密集又重複的運算需求非常龐大。理論上 CPU 也能做這些事,但效率很低,速度慢、耗電高、訓練時間長。

這時就輪到 GPU 發揮專長了。由於 GPU 擁有上百到上千個核心,能夠同時平行處理成千上萬個類似的小任務,不像 CPU 一次只能處理少數幾件事。因此在 AI 模型訓練這種情況下,GPU 能夠加速數十倍甚至上百倍,原本用 CPU 要跑幾週的訓練,改用 GPU 可能只需要幾天甚至幾小時,這也是為什麼會使用 GPU 來訓練模型。

總結

CPU 和 GPU 不是誰比較厲害的問題,而是各自有不同的任務角色。CPU 適合邏輯處理,GPU 則擅長大量數據的高速處理。在 AI 領域,兩者缺一不可,但在訓練大模型時,GPU 的加速效果是關鍵中的關鍵。了解這兩者的差異,不只能幫助你選擇適合的設備,也會讓你更清楚 AI 是怎麼運作的。

訓練模型只是 AI 發展的一部分。當模型訓練完成之後,接下來就是它真正被使用的階段,這個過程稱為推論 (Inference)。推論的意思是,AI 根據你給它的輸入,產生回應或做出預測。 在這個階段,你輸入給 AI 的問題,其實就是一種提示詞 (Prompt)。AI 會根據這些提示來判斷你的需求,並從模型的知識中找出最合適的答案。如果你想進一步了解如何設計出更有效的提示詞,可以參考這篇如何寫出好用的 Prompt。