到底甚麼是機器學習-MachinLearning

你是否曾好奇,電腦如何從一堆 0 和 1 的數據中,學會辨識圖片、翻譯語言,甚至做出決策?這一切的背後魔法,正是機器學習(Machine Learning, ML)——人工智慧(AI)的核心動力。機器學習讓電腦擁有「自學」的能力,無需明確的程式指令,就能從海量數據中挖掘規律,並應用於預測、分類或決策。隨著 AI 技術席捲全球,機器學習正以前所未有的方式改變我們的生活。如果你對神經網路的基礎概念還不熟悉,建議先閱讀我們的上一篇介紹:「AI為何如此「聰明」?一篇文讓你秒懂神經網路,掌握智慧科技新趨勢!」。接下來,讓我們一起深入探索機器學習的奧秘,揭開電腦如何從數據中提煉智慧的秘密!

從感知機開始:機器學習的起點

機器學習的歷史可以追溯到 1950 年代,當時電腦科學家法蘭克·羅森布拉特(Frank Rosenblatt)提出了感知機(Perceptron),這是神經網路和機器學習的雛形。感知機是一種簡單的二元分類器,模擬人腦神經元的運作,旨在讓機器分辨兩類數據,例如「是」或「否」。它的運作原理如下:

- 輸入與權重:感知機接收多個輸入(例如圖像的像素值),每個輸入乘以一個權重(Weight),這些權重決定每個輸入對最終結果的影響程度。

- 加權求和:感將所有輸入的加權值相加,再加上一個偏置(Bias),形成一個總和。

- 激活函數:總和透過一個激活函數(通常是一個簡單的階躍函數)轉換為輸出,例如 0 或 1,代表兩種分類。

![]()

以圖像辨識為例,假設要判斷一張圖片中的動物是貓還是狗,感知機會根據圖片的特徵(如耳朵形狀或毛色)進行加權計算,進而得出結論。更具體地說,實際操作時,圖片的像素值會被攤平為一串數字,輸入到模型的每個神經元中。透過反覆訓練並根據誤差調整權重,感知機逐漸學會辨識圖片的能力,猶如一個初學者通過練習逐步掌握新技能。

雖然感知機的概念簡單,但它奠定了神經網路的基礎。然而,感知機的局限性很快顯現:它只能處理線性可分的數據(即數據可以用一條直線分開),對於更複雜的問題(如 XOR 邏輯問題)無能為力。這一缺陷在 1969 年被馬文·閔斯基(Marvin Minsky)和西摩·帕普特(Seymour Papert)指出,導致機器學習研究一度陷入低潮。

從低谷到復興:深度學習的誕生

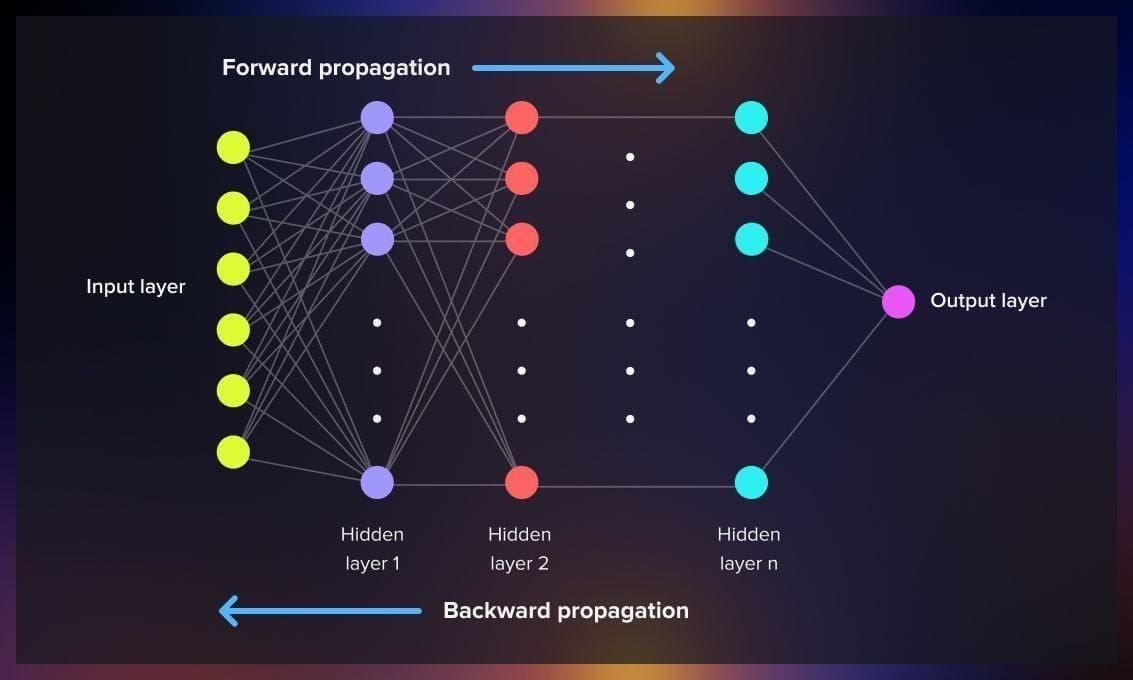

反向傳播的出現,讓神經網路從單純的「模仿神經元」進化為能夠解決複雜問題的工具。它的核心技術就是反向傳播 (Backpropagation) :當神經網路的預測與實際結果不符時,計算誤差並將其「反向」傳遞到網路的每一層,逐步調整每個神經元的權重和偏差。這種「從錯誤中學習」的過程,就好像我們在學習新技能時,通過一次次的嘗試和修正來進步。以手寫數字辨識的例子來說,當一台機器誤將手寫數字「7」辨識為「1」,反向傳播會根據誤差調整網路參數,讓下一次的預測更準確。這樣的學習模式並不要求模型在一開始就達到最好,而是透過一步步訓練,逐步改善模型在特定領域當中。

這項技術解決了感知機無法處理非線性問題的瓶頸,讓多層神經網路(即多層感知機,Multi-Layer Perceptron, MLP)成為可能。MLP 透過堆疊多層神經元,能捕捉數據中的複雜模式,開啟了神經網路的現代化進程。 近年來硬體革命大幅提升了計算能力。GPU(Graphics Processing Unit)和專為 AI 設計的張量處理單元 : TPU (Tensor Processing Unit),讓訓練複雜模型的時間從數週縮短到數小時甚至數分鐘。這種硬體加速讓研究者能實驗更深的網路結構,讓模型表現更好;其次數據爆炸提供了訓練深度學習模型的「燃料」。網路和數位化時代的到來,讓我們擁有了前所未有的海量數據 ,舉凡上傳到網路的圖片、影片等,經過加工都有可能成為訓練模型的資料,這些資料就是告訴模型如何識別特定場景的「教科書」。

機器學習的模型種類

深度學習的突破,離不開幾個改變遊戲規則的模型。它們各有專長,推動了從圖像識別到語言處理的革命。

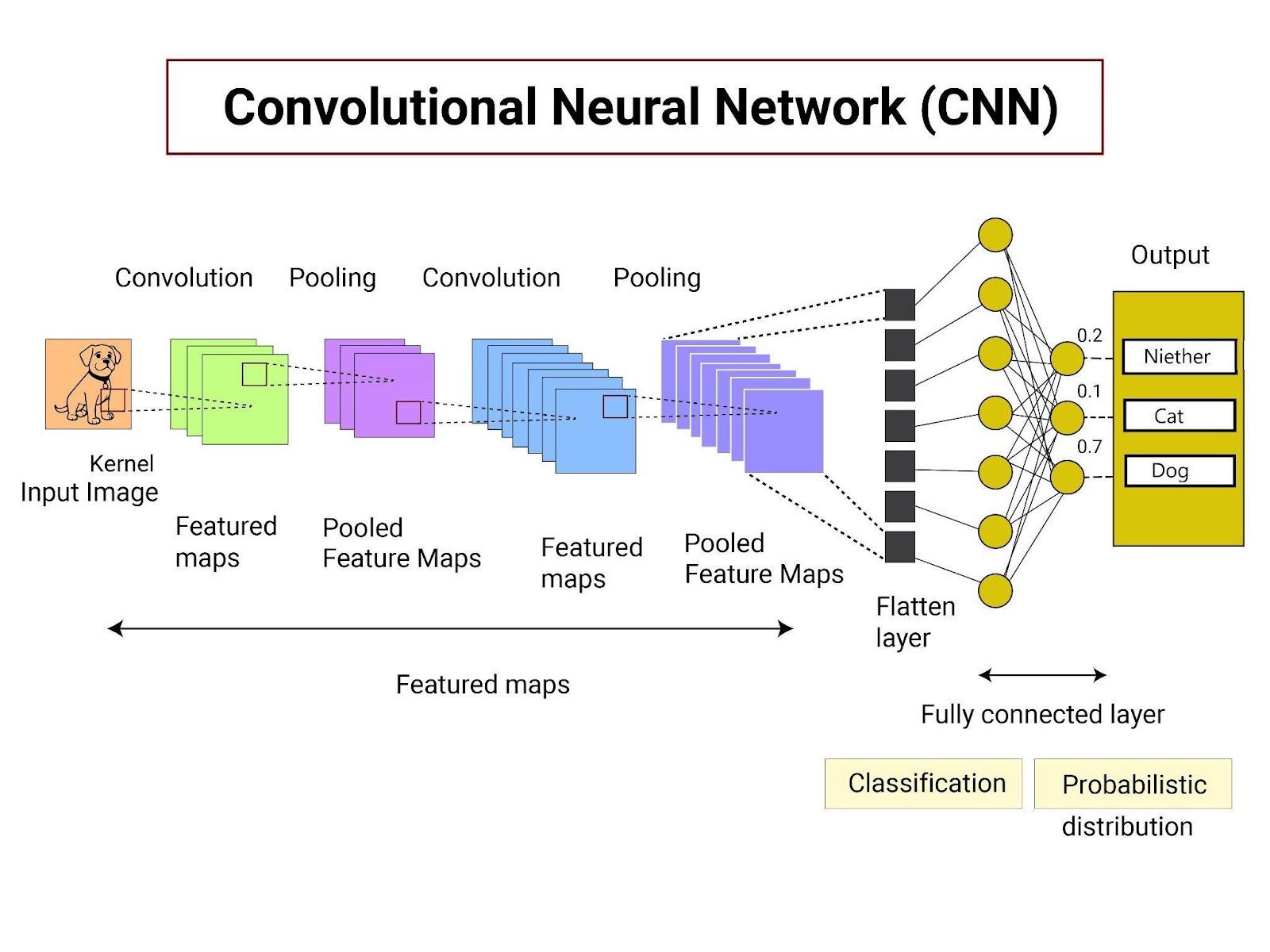

卷積神經網路(CNN):圖像的智慧之眼

你有沒有想過,電腦如何「看懂」圖片?卷積神經網路(CNN)就像一台模仿人類視覺的機器,能從圖片中自動提取特徵,從簡單的邊緣到複雜的輪廓。它的核心在於卷積層和池化層:卷積層像一個滑動窗口,捕捉圖片的局部特徵;池化層則濃縮信息,保留關鍵細節。這種結構讓 CNN 在圖像分類、人臉識別、甚至醫學影像分析(如檢測腫瘤)中表現突出。由於在圖片辨識當中只需要關注特定區域的影像,這樣的特性可以在大大減少全連接神經網路的權重計算,但並不會影響到模型的性能。

循環神經網路(RNN):序列數據的記憶大師

當數據有前後關聯,比如語音或文字會有前後文語義的問題,循環神經網路(RNN)就派上用場了。RNN 的獨特之處在於它的「記憶」能力:每處理一步,它都會保留前一步的信息,影響後續計算。這讓它非常適合語音識別、機器翻譯或文字生成。例如,早期的 Google 翻譯就依靠 RNN 的改良版本——長短期記憶網路(LSTM),實現了更流暢的語言轉換。

然而,傳統 RNN 在處理長序列時容易「忘記」早期信息。LSTM 和另一個改良版 GRU(門控循環單元)通過「門」機制,選擇性地保留重要信息,解決了這一問題。從 Siri 的語音解析到股票價格預測,RNN 家族在序列數據處理中扮演了關鍵角色。

Transformer:語言處理的革命者

2017 年,Google 提出的 Transformer 模型徹底改變了自然語言處理(NLP)。它放棄了 RNN 的循序處理,改用「注意力機制」,能同時關注序列中的所有元素,極大提升效率。想像你在讀一句話時,會特別注意關鍵詞,Transformer 也是如此,它能快速抓住句子的核心意思。

Transformer 催生了像 BERT 和 ChatGPT 這樣的現象級模型。BERT 擅長理解文字的上下文,改進了搜尋引擎的準確性;ChatGPT 則基於 GPT 架構,能生成流暢的對話,甚至寫詩或編故事。從翻譯到問答系統,Transformer 的影響力無遠弗屆,甚至開始應用於圖像處理,展現了它的多才多藝。

生成對抗網路(GAN):創造力的魔法

生成對抗網路(GAN)就像一場「藝術家與評論家」的對決。生成器試圖創造逼真的數據(如假人臉圖片),而鑑別器則負責分辨真假。兩者互相競爭,直到生成器產生的數據幾乎無懈可擊。GAN 的創造力令人驚嘆:它能生成高解析度的假人臉(像 NVIDIA 的 StyleGAN)、修復老照片,甚至創作抽象畫作。

DeepFake 技術就是 GAN 的代表應用,讓換臉影片栩栩如生,但也引發了倫理討論。從遊戲設計到數據增強,GAN 為創意產業和技術應用開闢了新天地。

當今的人工智慧技術,之所以能在圖像、語言、聲音等領域展現出驚人的能力,關鍵在於機器學習模型的持續演進與突破。從最初的感知機,到能處理複雜非線性問題的多層感知機(MLP),再到深度學習時代的卷積神經網路(CNN)、循環神經網路(RNN)、Transformer 與生成對抗網路(GAN),每一個模型都是人工智慧發展史上的里程碑。未來,隨著模型架構的精進與應用場景的多元化,機器學習將更加深入我們的日常生活,從輔助工具走向智慧夥伴。在這場 AI 革命中,了解這些基礎模型的運作原理與應用情境,不僅有助於掌握科技脈動,更是進入智慧時代的第一步。